在自然科学研究的广阔领域,数据智能正以前所未有的深度和广度重塑着科研范式。以机器学习、深度学习为代表的算法,不仅成为处理海量实验数据、模拟复杂自然现象、加速科学发现的核心工具,更在无形中构筑了一种新型的“算法权力”。这种权力体现在对研究路径的选择、对科学假设的验证乃至对“知识”本身的定义上,其影响力日益深远。这种权力并非无远弗届,其应用必须置于严谨的伦理框架与科学规范之下进行“校勘”,以确保自然科学研究的客观性、可重复性与向善性。

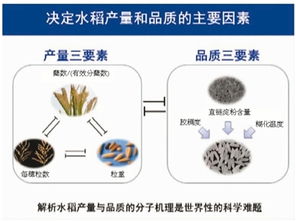

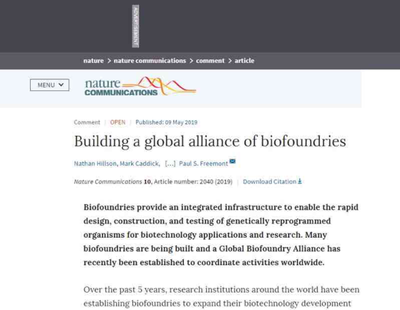

算法权力在自然科学研究中的积极赋能是显著的。在气候科学中,复杂的神经网络模型能够整合卫星遥感、海洋浮标与地面观测站的多源异构数据,以前所未有的精度模拟全球气候系统的演变,为应对气候变化提供关键决策依据。在天体物理学中,算法能够从淹没在噪声中的望远镜数据中自动识别出系外行星或引力波信号,极大地扩展了人类的宇宙认知边界。在生命科学领域,AI驱动的蛋白质结构预测(如AlphaFold)革命性地解决了长期困扰生物学界的难题,为疾病机理研究和药物设计开辟了新道路。这种由算法驱动的分析、预测与发现能力,构成了其核心权力——一种高效生成新知识与洞见的能力。

这种算法权力也潜藏着风险与挑战,亟待“边界”的设定与校勘。首要风险在于“算法黑箱”与可解释性问题。许多高性能的深度学习模型如同复杂的“黑箱”,其内部决策逻辑难以被人类研究者直观理解。在物理、化学等追求机理清晰性的学科中,一个无法解释其预测依据的模型,无论其准确性多高,都可能与科学追求根本解释的目标相悖。存在数据偏见与结果偏差的风险。算法模型的输出质量高度依赖于训练数据的代表性、全面性与无偏性。若训练数据本身存在系统性偏差(如历史观测数据的不均衡覆盖),或掺杂了人类先入为主的观念,算法不仅会固化这些偏见,还可能以“科学客观”的面貌将其放大,导致有缺陷的科学结论。例如,在生物多样性研究或流行病学模型中,若数据主要来自发达地区或特定群体,其结论的普适性将大打折扣。算法可能催生“唯数据论”或“唯模型论”的科研文化,使得一些传统但重要的理论思考、实验技巧和科研直觉被边缘化,长远来看可能窄化科学探索的视野。

因此,对数据智能的算法权力进行“校勘”,划定其合理边界,是自然科学健康发展的必然要求。这一校勘过程需多管齐下:

- 方法论校勘:大力推动可解释人工智能(XAI)在自然科学中的应用。鼓励开发与使用那些能在提供预测的揭示变量间因果关系或重要特征的模型(如某些可解释的机器学习算法、因果推断模型),促进“预测精度”与“机理理解”的平衡。科研论文中应要求对所用算法的原理、局限及结果的不确定性进行充分说明。

- 数据伦理校勘:建立科研数据全生命周期的伦理审查与管理规范。从数据采集的公正性、标注的客观性,到训练数据集的公开与可审计性,都需要建立标准。倡导数据共享的必须注重隐私保护(尤其在涉及人类或敏感生态数据时)和对数据来源社区的知识产权与惠益分享。

- 过程透明性与可重复性校勘:将算法代码、超参数设置、完整的训练与测试流程作为科研成果不可或缺的部分予以公开。推崇可重复的研究实践,鼓励同行使用相同代码与数据复现结果。学术期刊应强化对此方面的审稿要求。

- 价值导向校勘:科研共同体需进行持续的伦理对话,明确算法是服务科学发现的工具,而非替代科学思维的主体。应警惕算法可能被滥用于数据造假、成果包装或加剧科研功利化的倾向。教育体系需加强对未来科研人才的复合型培养,使其既精通计算技能,又深谙科学哲学与伦理准则。

- 治理框架校勘:自然科学领域的学会、基金资助机构及科研单位应协同制定针对算法应用的研究伦理指南和治理框架,明确责任主体,设立伦理审查委员会对涉及高风险算法应用的研究项目进行前置评估与持续监督。

数据智能的算法权力为自然科学研究带来了颠覆性的“加速器”,但其力量的发挥必须建立在坚实的伦理基石与严谨的规范框架之上。通过持续、审慎的“校勘”,我们方能确保算法真正服务于拓展人类知识边疆、增进人类福祉的科学初心,引导数据智能在探索自然奥秘的征途中,行稳而致远。